前言

在 Kafka 中防止消息丢失需要从生产者、Broker、消费者三个环节分别优化,确保消息的可靠传递和持久化。以下是各环节的详细配置和设计原理:

一、生产者端:确保消息成功发送到 Broker

1. 设置 acks=all

作用:要求所有 ISR(In-Sync Replicas)副本都确认收到消息后才认为发送成功。

配置:

props.put("acks", "all");

2. 启用重试机制

配置:设置重试次数(

retries)和重试间隔(retry.backoff.ms)。props.put("retries", 3); // 重试次数 props.put("retry.backoff.ms", 1000); // 重试间隔

3. 同步确认(必要时)

代码示例:使用

Future.get()等待发送结果。Future<RecordMetadata> future = producer.send(record); RecordMetadata metadata = future.get(); // 阻塞等待确认

二、Broker 端:确保消息持久化且高可用

1. 配置副本数(replication.factor)

建议值:至少设置为 3,确保每个 Partition 有多个副本。

创建 Topic 时指定:

bin/kafka-topics.sh --create --topic my-topic \ --partitions 3 --replication-factor 3 \ --bootstrap-server localhost:9092

2. 设置最小同步副本数(min.insync.replicas)

作用:定义必须确认的 ISR 副本数,避免消息因副本不足而丢失。

配置:在 Broker 或 Topic 级别设置。

# 修改 Topic 配置 bin/kafka-configs.sh --alter --entity-type topics --entity-name my-topic \ --add-config min.insync.replicas=2 \ --bootstrap-server localhost:9092

3. 禁用不安全的清理策略

配置:避免因日志清理(Log Cleanup)导致数据丢失。

log.retention.hours=168 # 保留7天 log.cleanup.policy=delete # 仅删除旧数据,不压缩

4. 确保副本同步机制(ISR)

监控 ISR:使用工具检查 ISR 状态,确保副本数健康。

markdown 复制 Topic: my-topic Partition: 0 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3

输出示例:

markdown 复制 Topic: my-topic Partition: 0 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3

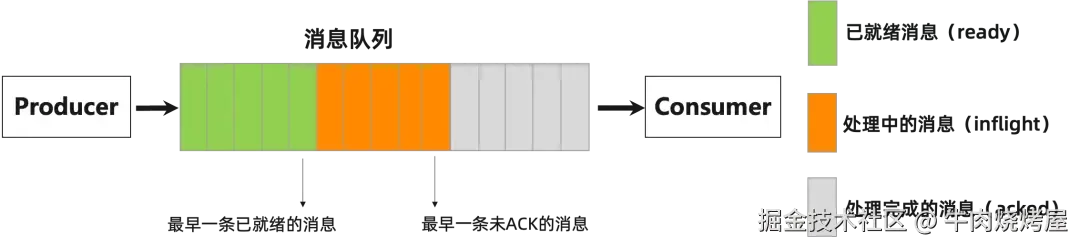

三、消费者端:确保消息处理完成后再提交 Offset

1. 关闭自动提交(enable.auto.commit=false)

配置:手动控制 Offset 提交时机。

props.put("enable.auto.commit", "false");

2. 处理完消息后手动提交 Offset

代码示例:

while (true) { ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100)); for (ConsumerRecord<String, String> record : records) { processRecord(record); // 处理消息 } consumer.commitSync(); // 手动同步提交 }

3. 处理消费者重平衡(Rebalance)

监听器:在重平衡前提交 Offset。

consumer.subscribe(Collections.singleton("my-topic"), new ConsumerRebalanceListener() { @Override public void onPartitionsRevoked(Collection<TopicPartition> partitions) { consumer.commitSync(); // 失去分区所有权前提交 Offset } });

四、灾难恢复与监控

1. 定期备份数据

使用

kafka-dump-log工具或第三方方案(如 Confluent 的 MirrorMaker)备份 Topic 数据。

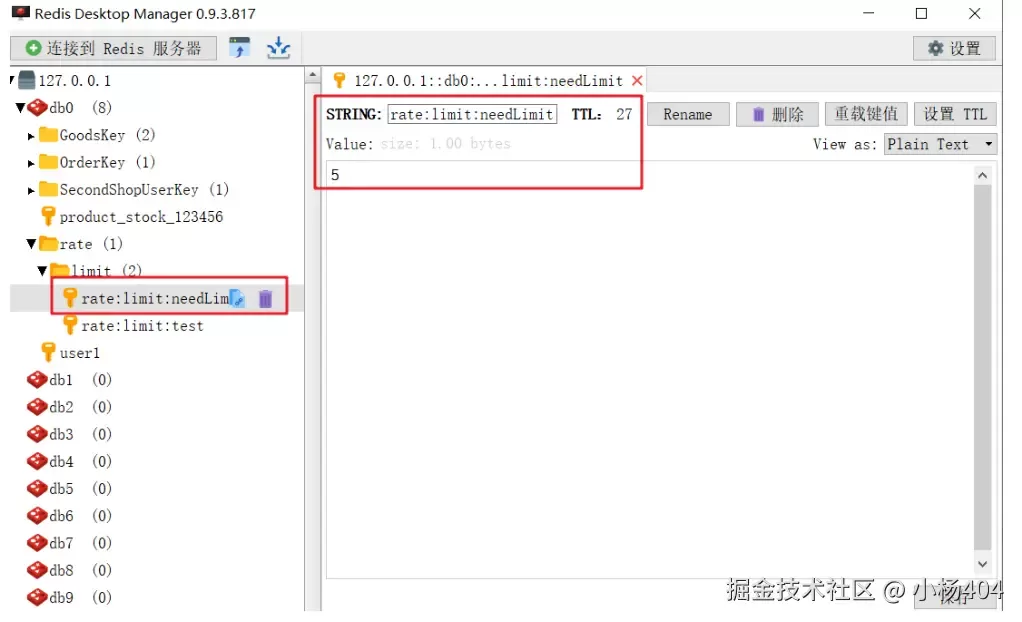

2. 监控关键指标

生产者监控:发送失败率、重试次数。

Broker 监控:ISR 副本数、Under-Replicated Partitions。

消费者监控:Consumer Lag(消息堆积量)。

3. 模拟故障测试

强制杀死 Leader Broker,验证副本选举和数据完整性。

五、常见问题与解决方案

问题 1:生产者发送超时(TimeoutException)

原因:网络抖动或 Broker 负载过高。

解决:增大

delivery.timeout.ms并启用重试。

问题 2:消费者重复消费

原因:Offset 提交过早(消息未处理完就提交)。

解决:确保处理完成后再提交 Offset。

问题 3:Broker 磁盘故障

解决:依赖多副本机制,自动切换到其他副本。

总结:防止消息丢失的最佳实践

| 环节 | 配置/行为 | 核心目标 |

|---|---|---|

| 生产者 | acks=all + 重试 + 同步确认 | 确保消息到达所有 ISR 副本 |

| Broker | replication.factor=3 + min.insync.replicas=2 | 高可用 + 持久化 |

| 消费者 | 手动提交 Offset + 处理完再提交 | 避免消息未处理就确认 |

通过以上配置和设计,Kafka 可在高吞吐场景下实现至少一次(At-Least-Once)语义,结合幂等性生产者(enable.idempotence=true)和事务机制,可进一步实现精确一次(Exactly-Once)语义。